2019 年,某知名公司的 AI 大模型应用遭到黑客攻击,导致大量用户隐私数据泄露,不仅使该公司损失了数百万美元,还严重损害了其品牌声誉。这一安全事件凸显了在 AI 技术飞速发展的今天,保障人工智能系统安全的重要性。随着企业加速将 AI 融入产品与运营中,薄弱的系统层安全措施可能导致 AI 大模型和用户隐私数据面临盗窃风险。被盗的 AI 模型可能被逆向工程、套壳或出售,这将削弱企业的投资,破坏客户信任,并使竞争对手迅速赶超。此外,端侧 AI 设备(如 AIPC、AI 手机、AI 车载系统等)上的个人隐私信息也可能被悄无声息地读取与记录,甚至发送到云端进行 AI 计算,极大地增加了个人隐私泄露的风险。

面对当前的 AI 安全威胁,企业面临着多重挑战的“忧与虑”。“近忧”包括数据泄露、模型被盗以及客户信任受损等直接风险;“远虑”则涉及长期的竞争劣势、知识产权损失以及合规性问题。作为 AI 基础设施提供商,阿里云深知这些挑战对用户的影响。基于“安全第一”的理念,阿里云携手中国科学院软件研究所、南湖实验室以及中国电子信息产业发展研究院等多家业界权威研究机构,共同发布了《机密计算保障人工智能系统安全研究报告》。该报告旨在通过引入机密计算技术,为用户提供更加安全可靠的 AI 基础设施,确保用户数据的隐私与安全,从而增强用户的信任,并推动数据可信流通与建设可信数据空间这一长远目标的健康发展。

《机密计算保障人工智能系统安全研究报告》强调了三个核心理念:一是从系统层面硬件开始确保 AI 安全;二是利用机密计算技术提升整体安全性;三是提供贯穿整个大模型数据生命周期的一体化安全解决方案。报告详细介绍了机密计算技术如何通过硬件强制实施的内存加密和访问控制隔离,确保 AI 模型数据在计算节点上的运行时安全性。结合 Confidential AI 框架,该解决方案能够提供从端到云的一体化 AI 安全与隐私保护能力。组织与企业可以根据报告中的标准,利用机密计算硬件提供的密码学数据加密和隔离能力,深度整合到自身产品中, 显著提高 AI 基础设施的安全标准,降低用户对 AI 基础设施的信任成本,并实现对用户数据隐私安全和云上大模型知识产权的有效保护。

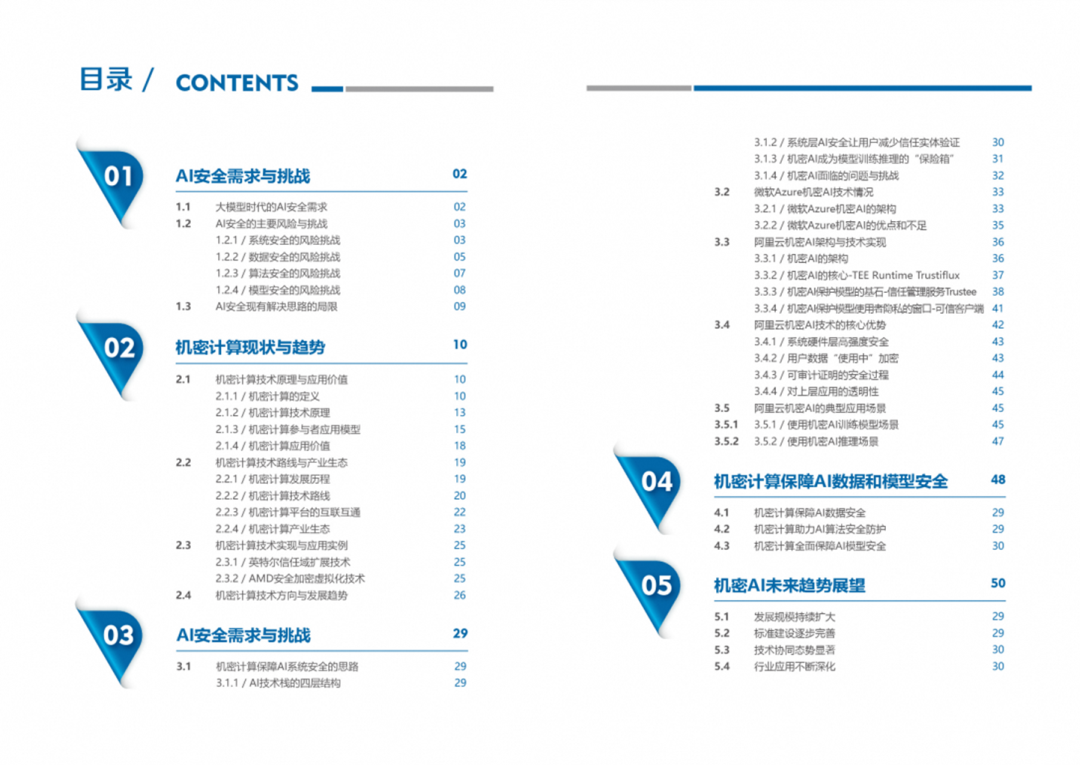

《机密计算保障人工智能系统安全研究报告》目录

26页PPT | 赛迪研究院联合阿里云、中科院软件所、南湖实验室发布《机密计算保障人工智能系统安全研究报告》

-

《机密计算保障人工智能系统安全研究报告》正文下载(复制链接至浏览器或点击阅读原文打开下拉至机密计算保障人工智能系统安全): https://www.aliyun.com/why-us/security-compliance#11